Ogni svolta importante nella storia della progettazione è iniziata con qualcosa che, almeno all’inizio, sembrava essere marginale. È accaduto con l’architettura parametrica, tra la fine degli anni Novanta e i primi Duemila, che appariva a molti come un esercizio per pochi, fatto di forme fluide, superfici relazionali, geometrie troppo complesse per sembrare realizzabili. Eppure, con il tempo, quella logica — la forma come risultato di un sistema più che di un gesto — si è inserita nei software, nei processi e nelle abitudini di lavoro, fino a diventare parte integrante del processo di progettazione contemporaneo.

Una dinamica simile si è ripetuta di recente con l’AI generativa. Dal 2022 strumenti come Midjourney, Stable Diffusion o DALL·E hanno introdotto la possibilità di creare immagini a partire da un testo. Architetture impossibili, città irrealistiche, mondi speculativi estremamente dettagliati hanno iniziato a invadere i nostri feed, diventando materiali utili per esprimere un concept, partecipare a concorsi, creare presentazioni.

Nonostante l’impatto, rimanevano ancorati alla rappresentazione. Ed è qui che entrano in gioco i world model.

Le immagini non bastano più

Se è vero che gli strumenti citati operano sul piano dell’immagine, non per questo si equivalgono. Nel 2021 DALL·E ha introdotto una novità radicale: un’immagine poteva essere letteralmente “scritta”. Midjourney, reso pubblico nel 2022, ha trasformato quella possibilità in un’estetica subito riconoscibile, diffondendo l’idea dell’AI come macchina dell’immaginazione più che come semplice generatore grafico. Nello stesso periodo è arrivato anche Stable Diffusion, che con il suo modello open-source ha ampliato l’accesso alla generazione di immagini ricostruite dal “rumore” di segnali visivi minimi, coinvolgendo comunità molto più ampie.

Nel febbraio 2024 OpenAI ha lanciato Sora, capace di produrre non più fotogrammi isolati ma video continui, con movimenti credibili di camera, profondità di campo coerente e una continuità visiva che ricorda quella di una troupe cinematografica. La versione più recente, rilasciata nel 2025, ha stabilizzato superfici, volumi e interazioni tra oggetti, riducendo effetti artificiosi e oscillazioni.

Ma, nonostante l’impatto, l’operazione rimane invariata: sono modelli che apprendono e ricombinano pattern visivi, non processi.

Un video può sembrare fisicamente plausibile, convincente, persino emozionante, ma questo non significa che il modello comprenda la dinamica che governa ciò che vediamo

Un video generato da Sora può sembrare fisicamente plausibile, convincente, persino emozionante, ma questo non significa che il modello comprenda davvero la dinamica che governa ciò che vediamo. Restituisce coerenza di pixel, non coerenza fisica o causale. E finché un sistema rimane uno strumento di visualizzazione, può ampliare l’immaginario, generare varianti, aprire possibilità, ma non può simulare effetti, rischi, impatti o comportamenti emergenti di un ambiente. Non può prevedere cosa accade quando più fattori interagiscono in uno spazio reale, né contribuire alle decisioni che guidano un progetto. È un limite evidente, soprattutto quando si parla di architettura, urbanistica e design.

A differenza dei modelli generativi visuali, i world model non producono immagini del mondo, ma mondi che funzionano davvero. Non generano una scena che sembra realistica: generano la logica interna che la rende possibile — come si diffonde la luce, come si distribuisce una folla, come cade un oggetto, come un flusso cambia direzione.

I world model, in poche parole

In altre parole, i world model non imitano l’aspetto di un fenomeno: ne apprendono le regole. Anche perché non nascono nel mondo della creatività né, tantomeno, in quello della rappresentazione visiva. Arrivano da tutt’altra storia: quella della robotica e dei tentativi di permettere alle macchine di capire come evolve un ambiente osservandolo, invece di ricevere istruzioni programmate da un ingegnere. L’idea compare nei primi studi di Jürgen Schmidhuber, già dagli anni ’90, e prende forma negli anni 2010 con il lavoro di DeepMind, OpenAI e dei laboratori impegnati nella guida autonoma.

Waymo, la società di Alphabet che sviluppa veicoli senza conducente, ne è forse l’esempio più immediato. Le sue auto leggono costantemente l’ambiente con lidar, radar e telecamere, e trasformano ciò che registrano in una simulazione interna dello spazio, in cui ogni pedone, bicicletta o veicolo ha una traiettoria probabile. Non conoscono le regole del traffico in anticipo, ma le apprendono osservando, valutando migliaia di micro-futuri mentre procedono. Esattamente quello che farebbe una persona, ma con una capacità predittiva immensamente più ampia.

I modelli generativi imitano l’aspetto di un fenomeno. I world model ne apprendono le regole

In robotica, questa capacità di “allucinare futuri plausibili” è diventata essenziale, perché permette a un robot di imparare a manipolare un oggetto senza dover ripetere migliaia di tentativi reali. La stessa logica sostiene modelli come MuZero, sviluppato da DeepMind nel 2019, che impara le regole di un sistema anche quando nessuno le conosce in anticipo, o Dreamer, che consente a un agente di costruire un modello interno del mondo e usarlo per immaginare scenari futuri.

È un approccio molto diverso dai motori di simulazione tradizionali, quelli in cui ogni dettaglio fisico doveva essere codificato a mano, come accadeva nei videogiochi delle generazioni precedenti. Se un world model osserva a sufficienza come si muove una folla in una stazione, può prevederne traiettorie e pattern anche in condizioni mai viste; se osserva come il traffico si accumula nel corso della giornata, può anticipare congestioni o deviazioni.

Perché cambieranno la progettazione

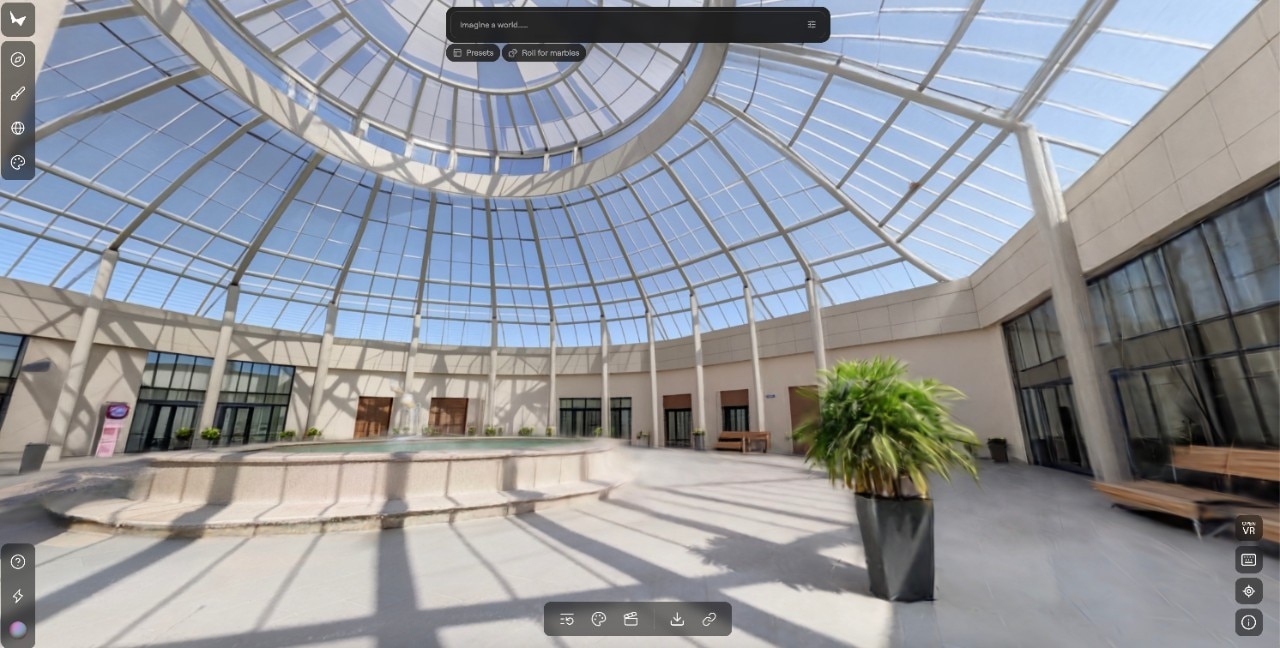

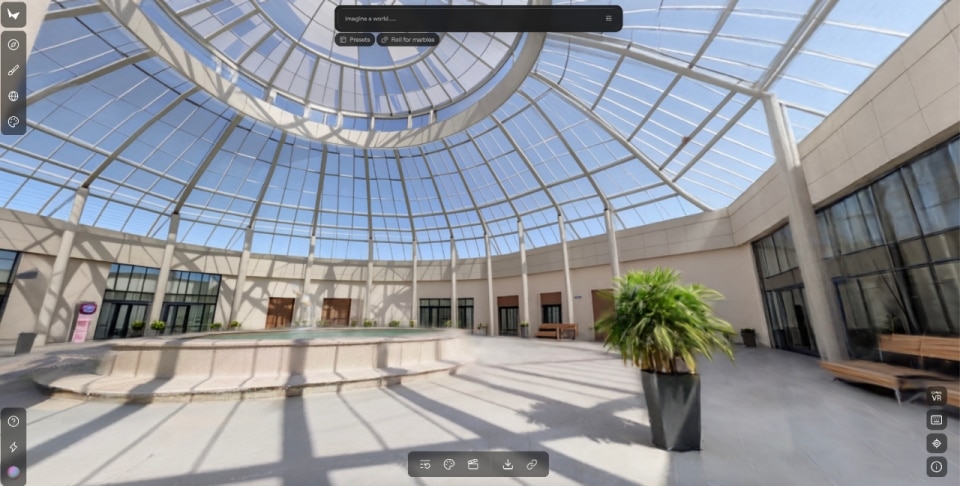

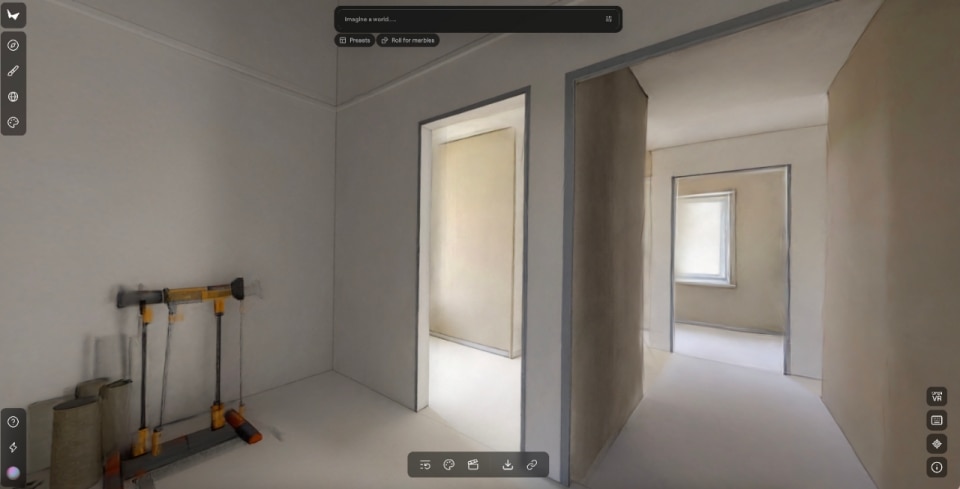

Per architetti, designer, urbanisti, e in generale per chi lavora con lo spazio, i world model rappresentano un cambiamento sostanziale. Permettono di osservare ambienti che ancora non esistono e di studiarli come sistemi dinamici. Si può vedere come si distribuisce una folla in un atrio durante un picco di afflusso, come un cortile accumula o disperde calore in estate, come varia la mobilità quando si modifica un asse stradale, come cambia il microclima di un quartiere con l’inserimento di un parco lineare. Anche gli interni diventano ambienti da analizzare nel loro comportamento, seguendo l’evoluzione d’uso nel tempo.

D’altronde la progettazione si è sempre basata sulla capacità di anticipare gli effetti di una decisione, ma anche la previsione più esperta può incontrare limiti strutturali. È il motivo per cui l’urbanistica resta una disciplina particolarmente vulnerabile agli effetti collaterali non previsti. La storia lo dimostra con chiarezza: dal crollo di Pruitt-Igoe a St. Louis — dovuto non a un difetto formale, ma all’incapacità di prevedere i comportamenti reali degli abitanti all’interno di uno schema troppo rigido — ai quartieri modernisti costruiti con percorsi pedonali separati, che sulla carta promettevano ordine e sicurezza e nella pratica hanno prodotto spazi deserti e poco accessibili. E ancora le piazze europee progettate come grandi superfici continue, che con l’aumento delle temperature si sono trasformate in isole di calore perché nessuno aveva immaginato come materiali, ombreggiature e microclima avrebbero reagito insieme.

Ovviamente non basta un world model a eliminare il rischio di errore; può però, in alcuni casi, anticiparlo prima che si manifesti, permettendo di osservare il comportamento di un ambiente simulato e valutare come un intervento ne modificherebbe equilibri, usi e reazioni. Non riduce il ruolo del progettista, anzi rafforza la collaborazione tra esperienza umana e capacità predittiva dei modelli. In questo senso, la trasformazione più significativa riguarda l’ingresso della dimensione temporale nel progetto: non più un effetto successivo, ma un parametro che contribuisce a plasmarlo fin dall’inizio.

L’obiettivo non è lasciare che la macchina prenda il controllo, ma dare all’utente un margine creativo reale

Il caso Marble

A guidare la svolta più discussa del momento è Fei-Fei Li, professoressa di Computer Science a Stanford e figura chiave nel campo della computer vision, che due settimane fa ha lanciato con la sua startup World Labs il primo world model commerciale, Marble.

Come racconta Rebecca Bellan su TechCrunch, Marble genera ambienti 3D persistenti e modificabili a partire da testo, immagini, video o layout spaziali. Non mondi che si deformano mentre ci si muove, ma spazi stabili e coerenti, esportabili in formati professionali e utilizzabili in pipeline reali come gaming, VFX e VR. Una delle funzioni più rilevanti è la possibilità di ampliare un ambiente o modificarne la struttura attraverso strumenti di editing integrati.

Il co-fondatore Justin Johnson sottolinea che l’obiettivo non è lasciare che la macchina prenda il controllo, ma offrire all’utente un margine creativo reale, immediato e diretto.

Marble è solo il primo tentativo di portare i world model fuori dai laboratori e dentro i processi produttivi. E le sue applicazioni non riguardano solo le discipline funzionali: nelle arti visive apre scenari nuovi, dalle installazioni che reagiscono al pubblico agli ambienti immersivi che evolvono secondo logiche simulate, fino a opere che non rappresentano un mondo ma lo attivano.