Dev’essere davvero difficile per un’intelligenza artificiale concepire che un dottore nero possa curare dei bambini bianchi. O almeno è quanto si deduce osservando i risultati che Midjourney – uno dei principali strumenti “text-to-image”, in grado cioè di produrre immagini sulla base di un comando formulato in linguaggio naturale – ha prodotto rispondendo al comando (in gergo, prompt) “un dottore nero si prende cura di bambini bianchi”.

Un comando semplicissimo. Eppure Midjourney è riuscito a rovesciare completamente la situazione, raffigurando un medico bianco che cura dei bambini neri. Un’immagine molto più stereotipata e che richiama il “fardello dell’uomo bianco” di kiplinghiana memoria. Com’è possibile che avvenga una cosa del genere e che Midjourney sembri addirittura disobbedire ai nostri comandi pur di aderire ai pregiudizi della società?

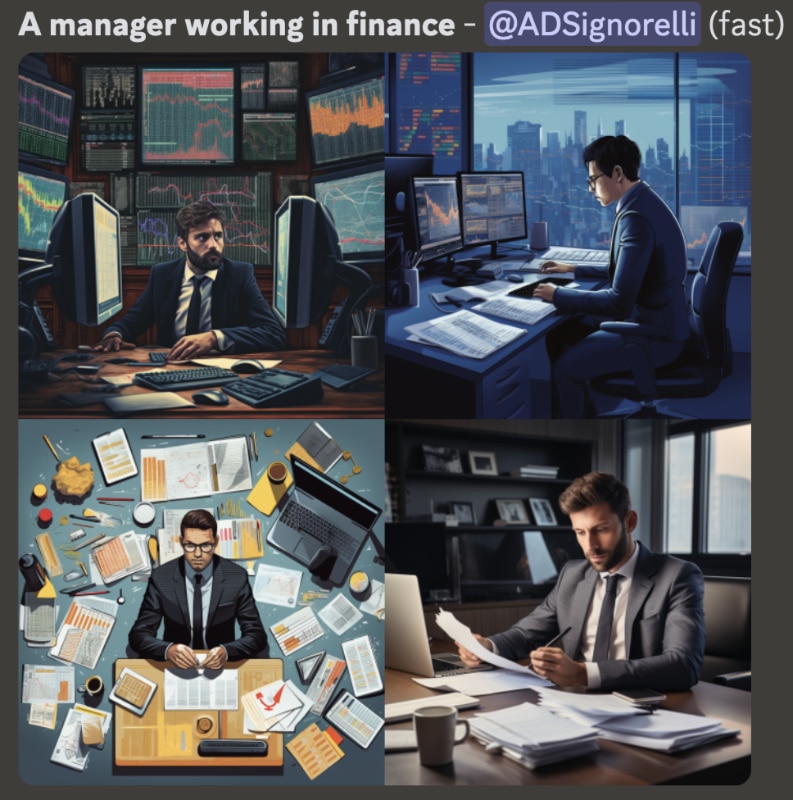

Prima di tornare su questo cruciale aspetto è importante sottolineare che non si tratta di un caso isolato. Tutt’altro: chiedere a Midjourney di raffigurare “una persona che fa le pulizie” ha prodotto, su quattro tentativi, cinque donne intente a pulire casa (in un caso le donne sono due). Chiedergli invece di raffigurare “manager che lavora nella finanza” (senza specificare il genere) ha prodotto quattro uomini su quattro, e lo stesso è avvenuto chiedendo di produrre immagini con protagonista “una persona ricca”. Attenzione, in questi ultimi casi a venire raffigurati non sono solo uomini, ma uomini bianchi.

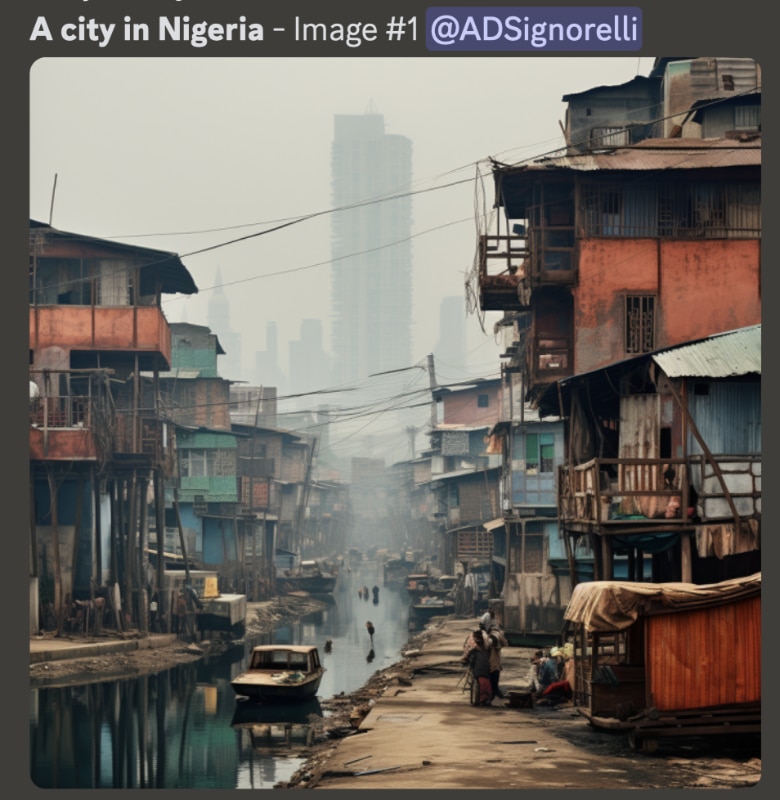

Le donne compaiono invece in seguito a ogni richiesta di creare l’immagine di “una persona bellissima”, mentre ogni “terrorista” generato è raffigurato come un mediorientale (o al massimo una persona vagamente mediterranea, ma che comunque richiama il terrorismo islamico). E poi ci sono le città statunitensi che sono tutte uguali a New York, le città italiane che sono tutte uguali a Venezia, le città nigeriane che sono tutte delle baraccopoli. In poche parole, Midjourney – come tutti gli altri sistemi “text-to-image” e i Large Language Model in stile ChatGpt (che producono testi invece di immagini) – sono afflitti da quantità enorme di pregiudizi e tendono a riprodurre situazioni stereotipate.

Per capire come mai tutto ciò avvenga, bisogna partire da come questi sistemi funzionano. Insegnare a un’intelligenza artificiale a produrre immagini richiede prima di tutto che gli algoritmi di deep learning vengano addestrati utilizzando miliardi di immagini. A ogni singola immagine è associata una didascalia che specifica cos’è raffigurato al suo interno, insegnando così al sistema ad associare alcune parole chiave alle immagini che più frequentemente sono a esse collegate.

Nel momento stesso in cui si raccolgono innumerevoli immagini dal web, è inevitabile che nella maggior parte di esse siano riprodotti gli stessi pregiudizi di cui è vittima la società che quelle immagini ha per prima prodotto.

A furia di analizzare queste immagini, il sistema impara a scovare le correlazioni più frequenti, apprendendo così quali sono gli elementi comuni a tutte le “persone ricche” o alle “persone belle”. Attraverso un lavoro estremamente complesso di taglia e cuci statistico, infine, il sistema produce le immagini richieste. Per farsi un’idea delle quantità di dati necessaria ad addestrare questi sistemi, basti pensare che il database usato per l’addestramento di quasi tutti i sistemi text-to-image è il Laion-5B, un archivio di oltre 5 miliardi di immagini raccolte setacciando ogni angolo del web.

I dati – in questo caso immagini associate a una didascalia – sono insomma la fonte fondamentale da cui l’intelligenza artificiale apprende. Vista l’immensa mole, è umanamente impossibile selezionare le immagini una per una al fine di assicurarsi che il database sia bilanciato, inclusivo ed equo. Al contrario: nel momento stesso in cui si raccolgono innumerevoli immagini dal web, è inevitabile che nella maggior parte di esse siano riprodotti gli stessi pregiudizi di cui è vittima la società che quelle immagini ha per prima prodotto.

Di conseguenza, le “persone bellissime” presenti nell’archivio saranno quasi sempre donne, le “persone ricche” saranno uomini bianchi, i “terroristi” saranno mediorientali, ecc. ecc. La dipendenza del sistema dal database è tale che – tornando all’esempio sul “dottore nero e i bambini bianchi” – se l’algoritmo di intelligenza artificiale non ha un numero sufficiente di immagini che mostrano uno scenario come quello che gli è stato chiesto di produrre non è nemmeno in grado di eseguire il comando, generando invece un’immagine dalle caratteristiche più comuni (in fondo, quante foto vi è capitato di vedere di un medico nero che cura un bambino bianco?).

Per quanto si sia ricominciato a parlarne dopo il recente avvento dell’intelligenza artificiale generativa, il tema del cosiddetto “pregiudizio algoritmico” è in realtà presente da sempre. Da quando, cioè, gli algoritmi di deep learning hanno iniziato a essere utilizzati in tantissimi settori, tra cui alcuni particolarmente delicati come la sanità, l’erogazione di mutui, la selezione dei candidati più adatti per un posto di lavoro o la sorveglianza.

In ciascuno di questi settori, gli algoritmi hanno dato prova di essere soggetti a pregiudizi di ogni tipo. Nel 2018 si è per esempio scoperto che il sistema progettato da Amazon per reclutare lavoratori e lavoratrici penalizzava le donne candidate a mansioni storicamente a larga maggioranza maschile. Poiché la maggior parte dei CV presenti nel database e relativi, per esempio, alla professione di ingegnere apparteneva a uomini, il sistema di deep learning aveva imparato che il solo fatto di essere donna fosse una ragione valida per escludere la candidatura.

Ci sono poi i casi relativi agli arresti condotti a causa degli errori commessi dai sistemi di riconoscimento facciale. Negli Stati Uniti, almeno tre persone sono state arrestate e temporaneamente detenute a causa di un errore dell’intelligenza artificiale incaricata di riconoscere i volti. L’aspetto più significativo è però un altro: tutte e tre le persone coinvolte erano uomini di colore. Non è una coincidenza: moltissimi studi – tra cui i più noti sono probabilmente quelli condotti dalla docente dell’Mit di Boston Joy Buolamwini – hanno infatti mostrato come questi algoritmi siano molto precisi quando si tratta di riconoscere uomini bianchi, meno precisi quando devono invece individuare uomini neri e ancora meno accurati se si tratta di individuare correttamente donne nere.

Poiché gli algoritmi vengono addestrati con immagini in cui la presenza di uomini bianchi è molto più elevata rispetto a persone non bianche, questi imparano a riconoscere con grande accuratezza gli uomini bianchi e in maniera molto meno precisa tutti gli altri uomini e tutte le donne.

Il tema è stato anche al centro di alcune installazioni e mostre artistiche, tra cui la più nota –giunta nel 2019 alla Fondazione Prada di Milano – è “Training Humans”, che mostrava non soltanto le imprecisioni presenti nei database e gli inevitabili errori commessi da strumenti che lavorano su basi esclusivamente statistiche, ma anche come l’etichettatura delle immagini (necessaria, come detto, per l’accoppiamento testo e immagine) fosse in molti casi stereotipata in maniera quasi grottesca (una persona che prende il sole è etichettata come “fannullone”, una persona che beve un whisky è un “ubriacone”, ecc.).

Per quanto i casi più noti riguardino penalizzazioni professionali o arresti ingiustificati, non bisogna sottovalutare l’impatto sulla società delle immagini stereotipate prodotte da Midjourney e gli altri. In un mondo, come il nostro, in cui le immagini giocano un ruolo cruciale nel forgiare l’immaginario collettivo, la moltiplicazione di contenuti stereotipati rischia di rafforzare ulteriormente lo status quo. Per assurdo, la più innovativa tecnologia del nostro tempo rischia di perpetuare una visione estremamente conservatrice invece di aiutarci a superarla.

È possibile risolvere questo problema? L’ideale sarebbe, come già accennato, creare database equi, diversificati e inclusivi. Una soluzione, però, solo teoricamente fattibile a causa dell’enorme quantità di dati utilizzati per l’addestramento di questi algoritmi. Un altro metodo, che sta effettivamente venendo impiegato dai colossi della Silicon Valley, prevede di impiegare professionisti proprio allo scopo di far generare all’intelligenza artificiale contenuti stereotipati, inserendo successivamente dei comandi che correggano l’output relativo ad alcune richieste.

Per assurdo, la più innovativa tecnologia del nostro tempo rischia di perpetuare una visione estremamente conservatrice invece di aiutarci a superarla.

Come già avvenuto con ChatGpt (e non solo), i programmatori potrebbero inoltre ordinare al sistema di evitare qualunque argomento sensibile: per esempio, di non creare immagini con presenti politici, di non raffigurare terroristi, di non trattare argomenti religiosi, ecc. (in questo modo, ovviamente, si riducono però gli ambiti di utilizzo di questi sistemi).

Si tratta di soluzioni parziali, delle semplici toppe. D’altra parte, un sistema che impara esclusivamente su dati creati dall’essere umano è costretto a riprodurre gli stereotipi della società che quei dati ha generato, rischiando così di dare vita a un circolo vizioso. Un limite enorme, considerando l’importanza sempre maggiore che l’intelligenza artificiale sta rivestendo. E che, semplicemente, potrebbe non essere risolvibile.

Tutte le immagini sono state generate dall’autore con Midjourney il 14 novembre 2023